本日、『Google Search Console Team』より、以下のような警告メッセージが送られてきました。

昨年10月にGoogleの技術ガイドラインの変更はあったけど

昨年10月にGoogleの技術ガイドラインの変更はありましたが、一部のJavaScriptをrobots.txt ファイルでブロックしていた事が要因のようです。

昨年10月以前のGoogleの仕様では・・

以前のGoogleの仕様では、 「JavaScript、Cookie、セッション ID、フレーム、DHTML、Flash などの特殊な機能が使用されているためにサイトの一部がテキスト ブラウザで表示されない場合、 検索エンジンのスパイダーがサイトをうまくクロールできない可能性があります。」という事でしたが、

現在は、以下のように言っています。

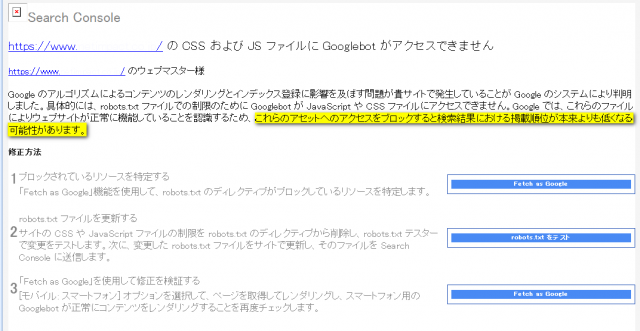

Google のアルゴリズムによるコンテンツのレンダリングとインデックス登録に影響を及ぼす問題が貴サイトで発生していることが Google のシステムにより判明しました。 具体的には、robots.txt ファイルでの制限のために Googlebot が JavaScript や CSS ファイルにアクセスできません。 Google では、これらのファイルによりウェブサイトが正常に機能していることを認識するため、これらのアセットへのアクセスをブロックすると検索結果における掲載順位が本来よりも低くなる可能性があります。

つまり、昔は、JavaScript、Cookie、セッション ID、フレーム、DHTML、Flash などを特殊な機能としていましたが 今は、CSSやJavaScriptをGoogleは、正しく読めるようになり、逆にブロックしているとサイトが正常に機能していることが認識できないと言うことのようです。

Googleの仕様の変化や使うシステムやセキュリティで判断が難しくなる??

以前は、GoogleがJavaScriptなどを正しく読めないなどの背景もあり、SEOのためにJSやCSSをブロックしたほうがいいという考え方でしたが、今は逆効果になってしまいます。

しかし一方で、サイト構築にWordpressなどのシステムが、汎用的に使われる時代となった今、WordpressのログインやPHPの入口や脆弱性を突く、不正アクセスが急速に増えています。

セキュリティ面から、外部からの不正アクセスを防ぐために、robots.txt ファイルで外部からの侵入をブロックする局面も増えてきています。

Googleのガイドラインに従わず、検索順位が落ちてしまうのも問題ですが

不正アクセスされるのも問題ですね。

これからは、セキュリティと Googleとの折り合いを上手につける技術や経験が求められる時代になったということですね。